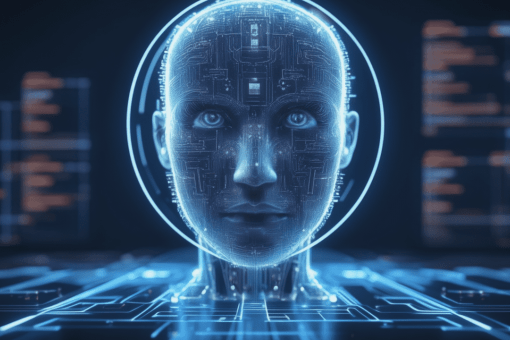

Единственным способом борьбы со злонамеренным использованием искусственного интеллекта (ИИ) может стать непрерывная разработка более мощного ИИ и передача его в руки правительства.

Похоже, к такому выводу пришла группа исследователей в недавно опубликованной статье под названием «Вычислительная мощность, а затем управление искусственным интеллектом».

Ученые из OpenAI, Кембриджа, Оксфорда и дюжины других университетов и институтов провели исследование как средство изучения текущих и потенциальных будущих проблем, связанных с управлением использованием и развитием ИИ.

Централизация

Основной аргумент статьи вращается вокруг идеи о том, что якобы единственный способ контролировать, кто будет иметь доступ к самым мощным системам искусственного интеллекта в будущем, — это контролировать доступ к оборудованию, необходимому для обучения и запуска моделей.

«Точнее, политики могли бы использовать компьютерные технологии, чтобы облегчить нормативную прозрачность ИИ, распределить ресурсы для достижения полезных результатов и ввести ограничения против безответственной или злонамеренной разработки и использования ИИ», – говорят исследователи.

В этом контексте «вычисления» относятся к базовому оборудованию, необходимому для разработки ИИ, такому как графические и центральные процессоры.

По сути, исследователи предполагают, что лучший способ помешать людям использовать ИИ для причинения вреда — это отрезать им источник. Это говорит о том, что правительствам потребуется разработать системы, с помощью которых можно будет отслеживать разработку, продажу и эксплуатацию любого оборудования, которое будет сочтено необходимым для разработки передового искусственного интеллекта.

Управление искусственным интеллектом

В каком-то смысле правительства по всему миру уже осуществляют «компьютерное управление». США, например, ограничивают продажу определенных моделей графических процессоров, обычно используемых для обучения систем искусственного интеллекта, в такие страны, как Китай.

Но, согласно исследованию, действительное ограничение возможности злоумышленников причинять вред с помощью ИИ потребует от производителей встроить в аппаратное обеспечение «аварийные выключатели». Это может дать правительствам возможность осуществлять «дистанционное правоприменение», например закрытие незаконных центров обучения искусственному интеллекту.

Однако, как отмечают исследователи, «наивные или плохо продуманные подходы к расчету управления несут значительные риски в таких областях, как конфиденциальность, экономические последствия и централизация власти».

Например, мониторинг использования оборудования в США может противоречить недавнему руководству Белого дома по разработке «проекта билля о правах ИИ», в котором говорится, что граждане имеют право защищать свои данные.

Аварийные выключатели могут быть DOA

Помимо этих опасений, исследователи также отмечают, что недавние достижения в области «эффективного в общении» обучения могут привести к использованию децентрализованных вычислений для обучения, построения и запуска моделей.

Это может затруднить правительствам поиск, мониторинг и отключение оборудования, связанного с незаконным обучением.

По мнению исследователей, это может не оставить правительствам иного выбора, кроме как занять позицию гонки вооружений против незаконного использования ИИ.

«Обществу придется своевременно и разумно использовать более мощные, управляемые вычисления, чтобы разработать защиту от возникающих рисков, создаваемых неуправляемыми вычислениями», – заключают авторы статьи.

"

"